การเรียนรู้ของเครื่อง

| ส่วนหนึ่งของเนื้อหา |

| การเรียนรู้ของเครื่อง และ การทำเหมืองข้อมูล |

|---|

|

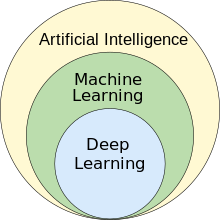

การเรียนรู้ของเครื่อง (อังกฤษ: machine learning - ML) เป็นส่วนหนึ่งของปัญญาประดิษฐ์ และเป็นสาขาวิชาที่พัฒนาและการศึกษาอัลกอริทึมเชิงสถิติที่สามารถเรียนรู้และพัฒนาตัวเองจากข้อมูล[1] (แบ่งเป็นชุดข้อมูลฝึกฝน ตรวจสอบ และทดสอบ (Training, validation, and test data sets)) แล้ววางนัยทั่วไปหรือคาดการณ์จากข้อมูลใหม่ที่ยังไม่เคยเห็น และทำภารกิจ (Task (computing)) ต่าง ๆ โดยไม่ต้องระบุคำสั่งอย่างชัดเจน[2] ตัวแบบโครงข่ายประสาทเทียมสามารถแสดงสมรรถนะเหนือแนวทางรูปแบบอื่น ๆ[3][4]

มีการประยุกต์ใช้การเรียนรู้ของเครื่องในหลากหลายสาขา ไม่ว่าจะเป็นการประมวลภาษาธรรมชาติ คอมพิวเตอร์วิทัศน์ การรู้จำคำพูด การกรองอีเมล (email filtering) การเกษตร และการแพทย์[5][6] ในการประยุกต์ใช้ทางธุรกิจ การเรียนรู้ของเครื่องเป็นที่รู้จักในอีกชื่อว่าวิทยาการวิเคราะห์เชิงคาดการณ์ (predictive analytics) แม้ว่าการเรียนรู้ของเครื่องไม่ได้มีพื้นฐานเชิงสถิติไปทุกรูปแบบ แต่วิธีวิทยาในสาขานี้มาจากสาขาวิชาสถิติเชิงคำนวณ (Computational statistics) เป็นสำคัญ

พื้นฐานทางคณิตศาสตร์ของการเรียนรู้ของเครื่องประกอบด้วยวิธีการการหาค่าเหมาะที่สุดเชิงคณิตศาสตร์ อีกหนึ่งสาขาวิชาที่เกี่ยวข้องกันคือการทำเหมืองข้อมูลซึ่งสนใจกับการวิเคราะห์ข้อมูลเชิงสำรวจ (exploratory data analysis) ผ่านการเรียนรู้แบบไม่มีผู้สอน[8][9]

การเรียนรู้ที่น่าจะถูกต้องโดยประมาณ (Probably approximately correct learning) เป็นกรอบคำอธิบายเชิงทฤษฎีสำหรับการเรียนรู้ของเครื่อง

ประวัติ[แก้]

อาเธอร์ ซามูเอล นักวิทยาศาสตร์คอมพิวเตอร์ชาวอเมริกัน ลูกจ้างไอบีเอ็ม และผู้บุกเบิกสาขาเกมคอมพิวเตอร์กับปัญญาประดิษฐ์ บัญญัติคำว่า machine learning ไว้ใน ค.ศ. 1959[10][11] และให้นิยามของการเรียนรู้ของเครื่องไว้ ว่า "เป็นสาขาที่ให้คอมพิวเตอร์มีความสามารถในการเรียนรู้โดยไม่ต้องโปรแกรมให้ชัดเจน"[12] ในช่วงเวลาเดียวกันนั้น มีการใช้คำว่า self-teaching computers (คอมพิวเตอร์สอนตัวเอง)[13][14]

หนึ่งในตัวแบบเรียนรู้ของเครื่องตัวแรก ๆ ในคริสต์ทศวรรษ 1950 เป็นโปรแกรมคอมพิวเตอร์ที่เขียนขึ้นโดยอาเธอร์ ซามูเอล ซึ่งคำนวณโอกาสชนะของแต่ละฝั่งในตาหมากรุก แต่ประวัติศาสตร์ของการเรียนรู้ของเครื่องมีรากเหง้าจากความพยายามและความปรารถนาที่จะศึกษากระบวนการรู้คิดของมนุษย์เป็นเวลานานนับสิบปี[15] ใน ค.ศ. 1949 นักจิตวิทยาชาวแคนาดา ดอนัลด์ โอ. เฮบบ์ (Donald O. Hebb) เผยแพร่หนังสือ Organization of Behavior ซึ่งเสนอโครงข่ายประสาททางทฤษฎี (Hebbian theory) ที่ประกอบด้วยปฏิสัมพันธ์ระหว่างเซลล์ประสาท[16] ตัวแบบปฏิสัมพันธ์ระหว่างเซลล์ประสาทของเฮบบ์วางรากฐานให้กับการทำงานของปัญญาประดิษฐ์และการเรียนรู้ของเครื่องด้วยโหนด หรือเซลล์ประสาทเทียม (artificial neuron) ที่คอมพิวเตอร์ใช้สื่อสารข้อมูล[15] นอกจากนี้ ยังมีนักตรรกวิทยา วอลเตอร์ พิตส์ (Walter Pitts) และวอร์เรน แมคคัลลอค (Warren Sturgis McCulloch) ผู้เสนอตัวแบบทางคณิตศาสตร์ของโครงข่ายประสาทเป็นอัลกอริทึมที่จำลองกระบวนการคิดของมนุษย์[15]

ช่วงต้นคริสต์ทศวรรษ 1960 บริษัทเรย์เธียนได้พัฒนา "เครื่องเรียนรู้" (learning machine) ทดลองด้วยหน่วยความจำแถบกระดาษเจาะรู (punched tape) ชื่อว่า ไซเบอร์ตรอน (Cybertron) สำหรับใช้วิเคราะห์สัญญาณโซนาร์ คลื่นไฟฟ้าหัวใจ และแบบแผนคำพูด ด้วยวิธีการเรียนรู้แบบเสริมกำลังระดับพื้นฐาน โดยมีมนุษย์ผู้ควบคุมคอยฝึกสอนซ้ำหลายครั้งให้รู้จำแบบแผน ผู้ควบคุมมีปุ่ม "goof" ที่ทำให้เครื่องประเมินค่าคำตัดสินที่ผิดพลาดใหม่อีกที[17] หนังสือตัวแทนของงานวิจัยด้านการเรียนรู้ของเครื่องในยุคคริสต์ทศวรรษ 1960 คือ Learning Machines ของนิลส์ จอห์น นิลสัน (Nils John Nilsson) เนื้อหาส่วนใหญ่เกี่ยวกับการเรียนรู้ของเครื่องเพื่อรู้จำแบบ[18] ความสนใจต่อการรู้จำแบบดำรงมาจนถึงคริสต์ทศวรรษ 1970 เช่นในหนังสือของริชาร์ด โอ. ดูดา (Richard O. Duda) และปีเตอร์ อี. ฮาร์ต (Peter E. Hart) Pattern Recognition and Scene Analysis[19] ใน ค.ศ. 1981 มีการเผยแพร่รายงานเกี่ยวกับกลยุทธ์การสอนให้โครงข่ายประสาทเทียมสามารถรู้จำอักขระ 40 ตัว (ตัวอักษร 26 ตัว ตัวเลข 10 ตัว สัญลักษณ์พิเศษ 4 ตัว) จากคอมพิวเตอร์เทอร์มินัล[20]

ทอม เอ็ม. มิตเชลล์ (Tom M. Mitchell) ได้ให้นิยามแบบรูปนัยแก่อัลกอริทึมที่สาขาการเรียนรู้ของเครื่องศึกษาว่า "กล่าวได้ว่าโปรแกรมคอมพิวเตอร์เรียนรู้จากประสบการณ์ E เพื่อทำงานประเภทหนึ่ง T ได้โดยมีประสิทธิผล P เมื่อสามารถทำงาน T ที่วัดผลด้วย P แล้วพัฒนาขึ้นจากประสบการณ์ E"[1]: 2 คำนิยามนี้เป็นการจำกัดความการเรียนรู้ของเครื่องในแง่การดำเนินการมากกว่าในแง่ความรู้สึกนึกคิด คล้ายข้อเสนอของแอลัน ทัวริง ในงานเขียนทรงอิทธิพล Computing Machinery and Intelligence ที่เปลี่ยนคำถามว่า "เครื่องจักรคิดได้หรือไม่" เป็นคำถามว่า "เครื่องจักรจะทำงานที่พวกเรา (ในฐานะสิ่งที่มีความคิดความอ่าน) ทำได้หรือไม่"[21]

ความสัมพันธ์กับสาขาอื่น[แก้]

ปัญญาประดิษฐ์[แก้]

ศาสตร์ด้านการเรียนรู้ของเครื่องเติบโตจากความพยายามค้นหาปัญญาประดิษฐ์ ในยุคแรก ๆ ของปัญญาประดิษฐ์ในฐานะสาขาวิชา นักวิทยาศาสตร์สนใจการสร้างเครื่องจักรที่สามารถเรียนรู้จากข้อมูลได้ จึงเริ่มทดลองด้วยวิธีการที่หลายหลาย ไม่ว่าจะด้วยวิธีการทางสัญลักษณ์ หรือด้วยโครงข่ายประสาทเทียม อันประกอบด้วยเพอร์เซปตรอนและตัวแบบอื่นเช่น ADALINE เป็นหลัก ซึ่งในเวลาต่อมาพบว่าเป็นเพียงการคิดค้นขึ้นซ้ำกับตัวแบบเชิงเส้นนัยทั่วไป (generalized linear model) จากวิชาสถิติ[23] และยังได้ใช้การให้เหตุผลเชิงน่าจะเป็น (probabilistic reasoning) โดยเฉพาะในการประยุกต์ด้านการวินิจฉัยโรคอัตโนมัติ (Computer-aided diagnosis)[24]: 488

อย่างไรก็ตาม นักวิจัยในสายปัญญาประดิษฐ์ยุคต่อมาเริ่มหันมาให้ความสำคัญกับแนวทางที่ใช้วิธีการทางตรรกศาสตร์และการแทนความรู้มากขึ้น จนทำให้ปัญญาประดิษฐ์เริ่มแยกตัวออกจากกับศาสตร์การเรียนรู้ของเครื่อง ระบบที่ใช้ความน่าจะเป็นเต็มไปด้วยปัญหาทางทฤษฎีและปฏิบัติ ทั้งในการแทนและการได้มาซึ่งข้อมูล[24]: 488 ต่อมาในปี 1980 ระบบผู้เชี่ยวชาญเริ่มโดดเด่นในสายของปัญญาประดิษฐ์จนหมดยุคของการใช้หลักสถิติ[25] งานวิจัยด้านการเรียนรู้เชิงสัญลักษณ์และบนฐานความรู้ยังคงออกมาเรื่อย ๆ จนนำมาสู่การโปรแกรมตรรกะเชิงอุปนัย ส่วนงานวิจัยด้านสถิติไปมีบทบาทนอกสาขาเฉพาะของปัญญาประดิษฐ์ เช่นในการรู้จำแบบและการค้นคืนสารสนเทศ[24]: 708–710, 755 นักวิจัยสายปัญญาประดิษฐ์และนักวิทยาศาสตร์คอมพิวเตอร์ได้ทิ้งงานวิจัยด้านโครงข่ายประสาทเทียมไปในเวลาเดียวกัน แต่ก็ยังมีนักวิจัยนอกสาขา เช่น จอห์น ฮอปฟิลด์ เดวิด โรเมลฮาร์ต และ เจฟฟรีย์ ฮินตัน ที่ยังพัฒนาโครงข่ายประสาทเทียมต่อไปในชื่อ "connectionism" โดยช่วงกลางคริสต์ทศวรรษ 1980 ได้คิดค้นหลักการการแพร่ย้อนกลับขึ้นใหม่ซ้ำ ที่ประสบความสำเร็จมากมายในเวลาต่อมา[24]: 25

การเรียนรู้ของเครื่อง ที่จัดระเบียบใหม่และเป็นที่รู้จักในฐานะสาขาวิชาเฉพาะตัว เริ่มเฟื่องฟูอีกทีในคริสต์ทศวรรษ 1990 โดยเปลี่ยนเป้าหมายจากปัญญาประดิษฐ์เป็นการจัดการแก้ไขปัญหาเชิงปฏิบัติ และเริ่มหันหน้าจากแนวทางของปัญญาประดิษฐ์เชิงสัญลักษณ์ (symbolic artificial intelligence) ที่ตกทอดมาจากสาขาปัญญาประดิษฐ์ ไปหาวิธีการและตัวแบบที่หยิบยืมจากสาขาสถิติศาสตร์ ตรรกศาสตร์คลุมเครือ และทฤษฎีความน่าจะเป็น[25]

การทำเหมืองข้อมูล[แก้]

ส่วนการเรียนรู้ของเครื่องกับการทำเหมืองข้อมูลมักจะใช้วิธีการเหมือน ๆ กันและมีส่วนคาบเกี่ยวกันอย่างเห็นได้ชัด สิ่งที่แตกต่างระหว่างสองศาสตร์นี้คือ

- การเรียนรู้ของเครื่อง เน้นเรื่องการพยากรณ์ข้อมูลจากคุณสมบัติที่ "รู้" แล้วที่ได้เรียนรู้มาจากข้อมูลชุดสอน

- การทำเหมืองข้อมูล เน้นเรื่องการค้นหาคุณสมบัติที่ "ไม่รู้" มาก่อนจากข้อมูลที่ได้มา กล่าวได้ว่าเป็นขั้นตอนการวิเคราะห์เพื่อค้นหา "ความรู้" ในฐานข้อมูล

สองศาสตร์นี้มีส่วนคาบเกี่ยวกันไม่น้อย คือ การทำเหมืองข้อมูลใช้วิธีการทางการเรียนรู้ของเครื่อง แต่มักจะมีเป้าหมายที่แตกต่างออกไป ส่วนการเรียนรู้ของเครื่องก็ใช้วิธีการของการทำเหมืองข้อมูลบางอย่าง เช่น การเรียนรู้แบบไม่มีผู้สอน หรือขั้นตอนการเตรียมข้อมูลเพื่อปรับปรุงความแม่นยำของการเรียนรู้ ความสับสนปนกันระหว่างสองสาขาวิชามีเหตุจากฐานคติพื้นฐานที่ทั้งสองยึดถือ ในสาขาการเรียนรู้ของเครื่อง ว่าประสิทธิภาพจะประเมินจากความสามารถในการผลิตซ้ำความรู้ที่รู้อยู่แล้ว ส่วนในสาขาการทำเหมืองข้อมูลหรือการค้นหาความรู้ ว่าภารกิจสำคัญคือการค้นหาความรู้ซึ่งไม่รู้มาก่อน วิธีการเรียนรู้แบบไม่มีผู้สอนย่อมด้อยประสิทธิภาพกว่าวิธีการแบบมีผู้สอนหากใช้กับความรู้ที่รู้อยู่แล้ว แต่ในงานของการทำเหมืองข้อมูลส่วนใหญ่นั้นจะไม่สามารถใช้วิธีแบบมีผู้สอนได้ เนื่องจากไม่มีชุดข้อมูลฝึกสอนดังกล่าวให้ใช้

การหาค่าเหมาะที่สุด[แก้]

การเรียนรู้ของเครื่องยังมีความคล้ายคลึงกับการหาค่าเหมาะที่สุด (optimization) นั่นคือ หลาย ๆ ปัญหาเกี่ยวกับการเรียนรู้มักจะถูกจัดให้อยู่ในรูปแบบของการหาค่าที่น้อยที่สุดของฟังก์ชันการสูญเสีย (loss function) บางอย่างจากข้อมูลชุดสอน ฟังก์ชันการสูญเสียหมายถึงความแตกต่างระหว่างค่าพยากรณ์ของตัวแบบที่กำลังสอนกับตัวอย่างจริงในปัญหา (เช่นการจัดประเภท เมื่อต้องการกำหนดประเภทให้ข้อมูลตัวอย่าง จะเป็นการฝึกสอนตัวแบบให้สามารถพยากรณ์ประเภทของชุดตัวอย่างซึ่งถูกกำหนดไว้ก่อนแล้วได้อย่างถูกต้อง)[26]

สถิติศาสตร์[แก้]

การเรียนรู้ของเครื่องมีความสัมพันธ์กับสถิติศาสตร์อย่างใกล้ชิดในแง่ของวิธีการ แต่เป้าหมายหลักต่างกัน สถิติศาสตร์หาข้ออนุมาน (statistical inference) เกี่ยวกับประชากรจากกลุ่มตัวอย่างกลุ่มหนึ่ง (sample (statistics) ในขณะที่การเรียนรู้ของเครื่องหาแบบแผนพยากรณ์ที่สามารถวางนัยทั่วไปได้[27] ไมเคิล ไอ. จอร์แดน (Michael I. Jordan) นักวิทยาศาสตร์คอมพิวเตอร์ชาวอเมริกันชี้ว่าแนวคิดของการเรียนรู้ของเครื่อง ทั้งหลักวิธีวิทยาและเครื่องมือทางทฤษฎี มีที่มาจากสถิติศาสตร์[28] และเสนอให้ใช้คำว่าวิทยาการข้อมูลไว้เรียกแทนทั้งสาขาวิชา[28]

ในการวิเคราะห์ทางสถิติแบบธรรมดา จำเป็นต้องคัดเลือกหาตัวแบบที่เหมาะสมที่สุดสำหรับชุดข้อมูลที่กำลังจะศึกษาไว้ก่อนล่วงหน้า ซึ่งคจะำนึงถึงตัวแปรที่สำคัญหรือเกี่ยวข้องทางทฤษฎีเท่านั้น โดยอิงกับประสบการณ์ในอดีต ตรงกันข้ามกับการเรียนรู้ของเครื่องซึ่งไม่ได้สร้างขึ้นด้วยตัวแบบที่กำหนดโครงสร้างไว้ก่อน แต่ข้อมูลจะเป็นตัวก่อร่างใหัตัวแบบซึ่งจะตรวจหาแบบแผนที่แฝงอยู่ในนั้น ยิ่งตัวแปรเข้าที่ใช้ใช้ฝึกตัวแบบมีจำนวนมากเท่าใด ตัวแบบสุดท้ายจะยิ่งมีความแม่นยำมากขึ้นเท่านั้น[29]

ลีโอ ไบรแมน (Leo Breiman) มองว่าสามารถแบ่งกรอบการสร้างแบบจำลองทางสถิติออกเป็นสองแนว แนวหนึ่งให้ความสำคัญกับข้อมูล ขณะที่อีกแนวให้ความสำคัญกับอัลกอริทึมมากกว่า[30] นักสถิติศาสตร์บางคนก็ยังปรับเอาหลักการของการเรียนรู้ของเครื่องไปใช้ นำไปสู่กับผสมผสานกันระหว่างสองศาสตร์ กลายเป็นศาสตร์ที่ชื่อการเรียนรู้ทางสถิติ[31]

ทฤษฎี[แก้]

หัวใจสำคัญของการเรียนรู้ของเครื่องคือ การทำให้โมเดลวางนัยทั่วไปจากประสบการณ์ที่ได้มา[7][32] การวางนัยทั่วไปในบริบทนี้คือความสามารถทำงานด้วยภารกิจหรือตัวอย่างใหม่ที่ไม่เคยเห็นมาก่อนได้อย่างแม่นยำภายหลังจากได้ประสบกับชุดข้อมูลฝึกแล้ว โดยทั่วไป ข้อมูลฝึกจะถูกดึงตัวอย่างมาจากการแจกแจงความน่าจะเป็นในรูปแบบที่ไม่รู้จัก (แต่ซึ่งถือว่าเป็นตัวแทนของข้อมูลที่ดำรงอยู่) และเครื่องจะต้องเรียนรู้เพื่อสร้างตัวแบบทั่วไปของข้อมูล ซึ่งจะทำให้สามารถพยากรณ์จากข้อมูลใหม่ ๆ ได้อย่างถูกต้องเพียงพอ

ทฤษฎีการเรียนรู้เชิงคำนวณ (computational learning theory) เป็นอีกสาขาหนึ่งทางวิทยาการคอมพิวเตอร์เชิงทฤษฎี (theoretical computer science) ซึ่งวิเคราะห์เชิงคำนวณเกี่ยวกับอัลกอริทึมและประสิทธิภาพของการเรียนรู้ของเครื่อง ผ่านตัวแบบการเรียนรู้ที่น่าจะถูกต้องโดยประมาณ (Probably approximately correct learning) อย่างไรก็ตาม ทฤษฎีเกี่ยวกับการเรียนรู้ไม่สามารถรับประกันประสิทธิภาพของอัลกอริทึมได้เพราะข้อมูลนั้นมีจำกัดและอนาคตมีความไม่แน่นอน แต่ทฤษฎีก็สามารถบอกขอบเขตบนความน่าจะเป็นได้ว่า ประสิทธิภาพน่าจะอยู่ในช่วงใด หนึ่งในวิธีการวัดความคลาดเคลื่อน (errors and residuals) ของการวางนัยทั่วไปคือการแยกความแปรปรวน-ความเอนเอียง (bias–variance decomposition)

สำหรับการวางนัยทั่วไปอย่างมีประสิทธิภาพสูงสุด สมมุติฐานควรมีความซับซ้อนที่ทัดเทียมกับความซับซ้อนของฟังก์ชันที่อยู่เบื้องหลังข้อมูล หากสมมุติฐานซับซ้อนน้อยกว่าฟังก์ชัน ตัวแบบจะเข้ารูปข้อมูลหลวมเกินไป (underfitting) และเมื่อเพิ่มความซับซ้อนของตัวแบบ ค่าความคลาดเคลื่อนหลังการฝึกก็จะลดลง แต่หากสมมุติฐานซับซ้อนเกินไป ตัวแบบก็จะประสบกับปัญหาการเข้ารูปสนิทเกิน (overfitting) และจะสามารถวางนัยทั่วไปได้แย่ลง[33]

นอกจากขอบเขตของประสิทธิภาพแล้ว นักวิทยาศาสตร์ด้านนี้ยังศึกษาความซับซ้อนด้านเวลา (time complexity) และความเป็นไปได้ของการเรียนรู้ของเครื่องด้วย ทฤษฎีการเรียนรู้เชิงคำนวณระบุว่าการคำนวณอันหนึ่งจะถือว่าเป็นไปได้ถ้าสามารถทำได้เสร็จภายในเวลาพหุนาม (polynomial time) โดยสามารถแบ่งออกเป็นสองชนิด หนึ่งคือผลลัพธ์เชิงบวก ซึ่งแสดงว่าฟังก์ชันบางประเภทสามารถเรียนรู้ได้ภายในเวลาพหุนาม และผลลัพธ์เชิงลบ ซึ่งแสดงว่าฟังก์ชันบางประเภทไม่สามารถเรียนรู้ได้ภายในเวลาพหุนาม

วิธีการเรียนรู้[แก้]

ประเภทของการเรียนรู้[แก้]

การเรียนรู้ของเครื่องสามารถแบ่งออกเป็นสามประเภทกว้าง ๆ โดยอิงจากกระบวนทัศน์การเรียนรู้ และขึ้นกับลักษณะของ "สัญญาณ" หรือ "ผลป้อนกลับ" ที่ส่งให้กับระบบที่กำลังเรียนรู้:

- การเรียนรู้แบบมีผู้สอน: เครื่องเรียนรู้จะรับเอากลุ่มตัวอย่างของข้อมูลขาเข้าพร้อมกับข้อมูลขาออกที่ประสงค์จาก "ผู้สอน" โดยมีเป้าหมายว่าจะเรียนรู้กฎทั่วไปที่จะส่งข้อมูลขาเข้าเป็นข้อมูลขาออก

- การเรียนรู้แบบไม่มีผู้สอน: เครื่องจะไม่ได้รับ "ฉลาก" หรือข้อมูลขาออกที่ประสงค์ และต้องค้นหาโครงสร้างภายในข้อมูลขาเข้าด้วยตัวของตัวเอง โดยอาจใช้ในการค้นหาแบบแผนที่แฝงตัวอยู่ในข้อมูล หรือใช้เป็นขั้นตอนหนึ่งในกระบวนการเรียนรู้ เช่นในขั้นการเรียนรู้ลักษณะ (feature learning)

- การเรียนรู้แบบเสริมกำลัง: เครื่องจะปฏิสัมพันธ์กับสภาพแวดล้อมที่มีพลวัต โดยจะต้องทำภารกิจบางอย่าง (เช่นการขับรถ (Self-driving car) หรือการเล่นเกมเอาชนะคู่แข่ง) และระหว่างควานหาทางในปริภูมิของปัญหา เครื่องจะได้รับผลป้อนกลับซึ่งเทียบได้กับรางวัล และเป็นสิ่งที่จะต้องทำค่าให้ได้สูงสุด[7]

แต่ละอัลกอริทึมมีข้อดีและข้อจำกัดแตกต่างกันไป ไม่มีอัลกอริทึมอันใดอันหนึ่งซึ่งสามารถใช้ได้กับปัญหาทุกรูปแบบ[34][35][36]

การเรียนรู้แบบมีผู้สอน (supervised learning) -[แก้]

ข้อมูลตัวอย่างและผลลัพธ์ที่ "ผู้สอน" ต้องการถูกป้อนเข้าสู่คอมพิวเตอร์ เป้าหมายคือการสร้างกฎทั่วไปที่สามารถเชื่อมโยงข้อมูลขาเข้ากับขาออกได้

นอกจากนี้ยังมีการเรียนรู้ความคล้าย (similarity and metric learning) โดยเครื่องจะมีตัวอย่างของคู่ที่ถูกมองว่าคล้ายมากและคู่ที่ถูกมองว่าคล้ายน้อย เครื่องจะต้องหาฟังก์ชันความคล้ายออกมาที่สามารถทำนายได้ว่าวัตถุใหม่นั้นมีความคล้ายมากน้อยเพียงใด มักใช้ในระบบแนะนำ (recommendation system)

การเรียนรู้แบบไม่มีผู้สอน (unsupervised learning)[แก้]

ไม่มีการทำฉลากใด ๆ และให้คอมพิวเตอร์หาโครงสร้างของข้อมูลขาเข้าเอง

วิธีการหลักที่นิยมใช้ได้แก่ การแบ่งกลุ่มข้อมูล อันเป็นการจัดกลุ่มของข้อมูลสำรวจให้ตกอยู่ในเซ็ตย่อย (เรียกว่า กลุ่ม หรือ cluster) โดยที่ข้อมูลที่อยู่ในกลุ่มเดียวกันจะมีความคล้ายคลึงกันตามเกณฑ์ที่ตั้งเอาไว้ ในข้อมูลที่อยู่คนละกลุ่มจะมีความแตกต่างกัน เทคนิคการแบ่งกลุ่มข้อมูลแต่ละเทคนิคก็มีสมมติฐานของโครงสร้างข้อมูลไม่เหมือนกัน โดยปกติแล้วมักจะมีการนิยาม การวัดค่าความเหมือน การเกาะกลุ่มภายใน และ การแยกกันระหว่างกลุ่ม ที่แตกต่างกัน การแบ่งกลุ่มข้อมูลจัดเป็นวิธีการเรียนรู้แบบไม่มีผู้สอน และเป็นวิธีที่ใช้กันทั่วไปในการวิเคราะห์ข้อมูลทางสถิติ

การเรียนรู้แบบเสริมกำลัง (reinforcement learning)[แก้]

คอมพิวเตอร์มีปฏิสัมพันธ์กับสิ่งแวดล้อมที่เปลี่ยนไปตลอดเวลาโดยคอมพิวเตอร์จะต้องทำงานบางอย่าง (เช่น ขับรถ) โดยที่ไม่มี "ผู้สอน" คอยบอกอย่างจริงจังว่าวิธีการที่ทำอยู่นั้นเข้าใกล้เป้าหมายแล้วหรือไม่ ตัวอย่างเช่น การเรียนรู้เพื่อเล่นเกม การเรียนรู้แบบเสริมกำลัง พิจารณาว่า เอเยนต์ ควรจะมี การกระทำ ใดใน สิ่งแวดล้อม เพื่อที่จะได้ รางวัล สูงสุด อัลกอริทึมของการเรียนรู้แบบเสริมกำลังนี้พยายามจะหา นโยบาย ที่เชื่อมโยง สถานะ ของโลกเข้ากับการกระทำที่เอเยนต์ควรจะทำในสถานะนั้น ๆ การเรียนรู้แบบเสริมกำลังนี้มีความแตกต่างไปจากการเรียนรู้แบบมีผู้สอนตรงที่ว่า คอมพิวเตอร์จะไม่รู้เลยว่าอะไรถูกอะไรผิด กล่าวคือ ไม่มีการบอกอย่างชัดเจนว่าการกระทำใดยังไม่ดี

การเรียนรู้แบบกึ่งมีผู้สอน (semi supervised Learning)[แก้]

เป็นการเรียนรู้อีกแบบหนึ่งที่ระหว่างการเรียนรู้แบบมีผู้สอนกับการเรียนรู้แบบไม่มีผู้สอน โดยที่ "ผู้สอน" จะไม่สอนอย่างสมบูรณ์ นั่นคือ บางข้อมูลในเซ็ตการสอนนั้นขาดข้อมูลขาออก

ทรานดักชัน (transduction)[แก้]

เป็นกรณีพิเศษของการเรียนรู้แบบกึ่งมีผู้สอนคือใช้ชุดตัวอย่างที่มีทั้งฉลากและไม่มีฉลากในการเรียนรู้ แต่จุดประสงค์ไม่ใช่การสร้างแบบจำลอง แต่เป็นการใส่ฉลากให้กับตัวอย่างที่ไม่มีฉลากที่ใช้ในการฝึกสอน เนื่องจากการเรียนรู้แบบ ทรานดักชันไม่มีแบบจำลอง ผลการเรียนรู้จึงไม่สามารถนำไปใช้กับข้อมูลชุดใหม่ได้โดยตรง

การเรียนวิธีการเรียน (learning to learn, meta-learning)[แก้]

เป็นวิธีที่จะเรียนวิธีการเรียนรู้ของตนเอง โดยปรับปรุงอคติแบบอุปนัยที่เป็นข้อสมมติฐานที่อัลกอริทึมใช้ในการเรียนรู้จากประสบการณ์ที่ผ่านมา

การเรียนรู้ด้วยการแทน (representation learning)[แก้]

การเรียนรู้บางอย่างโดยเฉพาะการเรียนรู้แบบไม่มีผู้สอนนั้นพยายามจะค้นหาการแทนข้อมูลขาเข้าที่ดีขึ้นเมื่อมีชุดข้อมูลฝึก ตัวอย่างของการเรียนรู้ด้วยการแทนนี้ได้แก่ การวิเคราะห์องค์ประกอบหลักและการแบ่งกลุ่มข้อมูล อัลกอริทึมการเรียนรู้ด้วยการแทนมักจะเปลี่ยนข้อมูลไปในรูปแบบที่มีประโยชน์แต่ยังคงรักษาสารสนเทศของข้อมูลเอาไว้ มักใช้ในกระบวนการเตรียมข้อมูลก่อนจะแบ่งประเภทข้อมูลหรือพยากรณ์ ตัวอย่างอื่นของการเรียนรู้ด้วยการแทนได้แก่ การเรียนรู้เชิงลึก

การเรียนรู้พจนานุกรมแบบห่าง (sparse dictionary learning)[แก้]

กฎความสัมพันธ์ (association rule learning)[แก้]

เป็นวิธีการหาความสัมพันธ์ที่น่าสนใจจากตัวแปรในฐานข้อมูลขนาดใหญ่ นอกจากนี้ยังมีการโปรแกรมตรรกะเชิงอุปนัย เป็นวิธีการเรียนรู้จากกฎโดยใช้การโปรแกรมตรรกะ เมื่อมีข้อมูลเบื้องหลังและกลุ่มของตัวอย่างที่เป็นฐานข้อมูลตรรกะแล้ว โปรแกรมตรรกะเชิงอุปนัยจะหาโปรแกรมตรรกะที่ครอบคลุมตัวอย่างบวกแต่ไม่รอบคลุมตัวอย่างลบ

แบบจำลอง[แก้]

การเรียนรู้ของเครื่องเกี่ยวข้องกับการสร้างแบบโมเดล (model) ซึ่งเกิดจากการสอนด้วยข้อมูลสอนและสามารถพยากรณ์ข้อมูลที่เข้ามาใหม่ได้ โมเดลมีหลากหลายรูปแบบ ได้แก่

โครงข่ายประสาทเทียม (artificial neural networks)[แก้]

โครงข่ายประสาทเทียม เป็นอัลกอริทึมที่ได้แรงบันดาลใจมาจากโครงสร้างและการทำงานของเซลล์ประสาทในสมอง การคำนวณของโครงข่ายประสาทเทียมถูกสร้างเป็นโครงสร้างของการเชื่อมต่อของประสาทเทียมแต่ละตัว ประมวลผลข้อมูลโดยหลักการการเชื่อมต่อ โครงข่ายประสาทเทียมสมัยใหม่เป็นเครื่องวิเคราะห์ทางสถิติที่ไม่เป็นเชิงเส้น มักใช้ในการจำลองความสัมพันธ์ที่ซับซ้อนระหว่างข้อมูลขาเข้าและขาออก เพื่อหารูปแบบจากข้อมูล หรือเพื่อหาโครงสร้างทางสถิติระหว่างตัวแปรที่สำรวจ

การเรียนรู้ต้นไม้ตัดสินใจ (decision tree learning)[แก้]

การเรียนรู้ต้นไม้ตัดสินใจ ใช้ต้นไม้ตัดสินใจในการสร้างโมเดลที่พยากรณ์ได้ ซึ่งจะเชื่อมโยงข้อมูลสังเกตการณ์เข้ากับข้อมูลปลายทาง

ซัพพอร์ตเวกเตอร์แมชชีน (support vector machines)[แก้]

ซัพพอร์ตเวกเตอร์แมชชีน เป็นหนึ่งในวิธีการเรียนรู้แบบมีผู้สอน ใช้เพื่อการการแบ่งประเภทข้อมูลและการวิเคราะห์การถอดถอย เมื่อมีข้อมูลฝึกมาให้และแต่ละข้อมูลถูกจัดอยู่ในประเภทใดประเภทหนึ่งจากสองประเภท ซัพพอร์ตเวกเตอร์แมชชีนจะสร้างแบบจำลองที่สามารถพยากรณ์ได้ว่าตัวอย่างใหม่นี้จะตกอยู่ในกลุ่มใด

การวิเคราะห์ความถดถอย (regression analysis)[แก้]

เครือข่ายแบบเบย์ (Bayesian networks)[แก้]

เครือข่ายแบบเบย์ เป็นโมเดลความน่าจะเป็นเชิงกราฟที่แทนกลุ่มของตัวแปรสุ่มและความเป็นอิสระแบบมีเงื่อนไขด้วยกราฟอวัฏจักรระบุทิศทาง ตัวอย่างเช่น เครือข่ายแบบเบย์สามารถใช้แทนความสัมพันธ์เชิงความน่าจะเป็นระหว่างอาการแสดงกับโรคได้ เมื่อมีอาการแสดง เครือข่ายจะคำนวณความน่าจะเป็นที่จะเป็นโรคแต่ละโรค มีหลายอัลกอริทึมที่สามารถอนุมานและเรียนรู้ได้อย่างมีประสิทธิภาพ

ขั้นตอนวิธีเชิงพันธุกรรม (genetic algorithms)[แก้]

ขั้นตอนวิธีเชิงพันธุกรรม เป็นการค้นหาแบบฮิวริสติกที่เลียนแบบกระบวนการคัดเลือกตามธรรมชาติในช่วงวิวัฒนาการของสิ่งมีชีวิต โดยใช้เทคนิคการกลายพันธุ์ของยีนและการไขว้เปลี่ยนของโครโมโซมในการหาประชากรที่น่าจะอยู่รอดเพื่อพาไปสู่คำตอบของปัญหาได้ อัลกอริทึมนี้ได้รับความสนใจมากในสาขาการเรียนรู้ของเครื่องในช่วงทศวรรษ 1980 และ 1990 และเทคนิคทางการเรียนรู้ของเครื่องก็ช่วยปรับปรุงประสิทธิภาพของขั้นตอนวิธีเชิงพันธุกรรมและขั้นตอนวิธีเชิงวิวัฒนาการเช่นกัน

การประยุกต์[แก้]

การเรียนรู้ของเครื่อง สามารถประยุกต์ใช้งานได้หลากหลาย เช่น

- เว็บไซต์ปรับรูปแบบเองได้ (Adaptive website)

- การคำนวณเชิงอารมณ์ (affective computing)

- ชีวสารสนเทศศาสตร์ (bioinformatics)

- ส่วนต่อประสานสมอง–คอมพิวเตอร์ (brain–computer interface)

- เคมีสารสนเทศศาสตร์ (chemoinformatics)

- การจัดประเภทลำดับดีเอ็นเอ

- คอมพิวเตอร์วิทัศน์ (computer vision)

- การตรวจจับการฉ้อโกงบัตรเครดิต (credit card fraud)

- การเล่นเกมกลยุทธ์

- การค้นคืนสารสนเทศ (information retrieval)

- การตรวจสอบการฉ้อโกงทางอินเทอร์เน็ต (Internet fraud)

- การรับรู้ของเครื่อง (Machine perception)

- การวินิจฉัยทางการแพทย์ (medical diagnosis)

- การประมวลผลภาษาธรรมชาติ (natural language processing)

- การหาค่าเหมาะที่สุด (optimization)

- ระบบแนะนำ (recommender systems)

- ระบบเคลื่อนไหวของหุ่นยนต์

- เสิร์ชเอนจิน (search engines)

- วิศวกรรมซอฟต์แวร์ (software engineering)

- การรู้จำเสียงพูด (speech recognition)

ซอฟต์แวร์[แก้]

ซอฟต์แวร์เสรีและซอฟต์แวร์โอเพนซอร์ซ[แก้]

ซอฟต์แวร์จำกัดสิทธิ์ที่มีรุ่นฟรีและโอเพนซอร์ซ[แก้]

ซอฟต์แวร์จำกัดสิทธิ์[แก้]

ดูเพิ่ม[แก้]

- ข้อมูลขนาดใหญ่ (Big data)

- การทำเหมืองข้อมูล (Data mining)

- วิทยาการข้อมูล (Data science)

อ้างอิง[แก้]

- ↑ 1.0 1.1 Mitchell, T. (1997). Machine Learning. McGraw Hill. ISBN 978-0-07-042807-2.

- ↑ นิยามว่า "without being explicitly programmed" (โดยไม่ต้องโปรแกรมให้ชัดเจน) มักให้ที่มาว่ามาจาก อาเธอร์ ซามูเอล ผู้บัญญัติศัพท์ "machine learning" ใน ค.ศ. 1959 แต่ไม่พบว่ามีวลีนี้ในเอกสารคำต่อคำ แต่อาจเป็นการถอดความ (paraphrase) ที่ปรากฏในภายหลัง ดูที่ "Paraphrasing Arthur Samuel (1959), the question is: How can computers learn to solve problems without being explicitly programmed?" ใน Koza, John R.; Bennett, Forrest H.; Andre, David; Keane, Martin A. (1996). "Automated Design of Both the Topology and Sizing of Analog Electrical Circuits Using Genetic Programming". Artificial Intelligence in Design '96. Artificial Intelligence in Design '96 (ภาษาอังกฤษ). Springer, Dordrecht. pp. 151–170. doi:10.1007/978-94-009-0279-4_9. ISBN 978-94-010-6610-5.

- ↑ "What is Machine Learning?". IBM (ภาษาอังกฤษแบบอเมริกัน). สืบค้นเมื่อ 27 มิถุนายน 2023.

- ↑ Zhou, Victor (20 ธันวาคม 2019). "Machine Learning for Beginners: An Introduction to Neural Networks". Medium (ภาษาอังกฤษ). เก็บจากแหล่งเดิมเมื่อ 9 มีนาคม 2022. สืบค้นเมื่อ 15 สิงหาคม 2021.

- ↑ Hu, Junyan; Niu, Hanlin; Carrasco, Joaquin; Lennox, Barry; Arvin, Farshad (2020). "Voronoi-Based Multi-Robot Autonomous Exploration in Unknown Environments via Deep Reinforcement Learning". IEEE Transactions on Vehicular Technology. 69 (12): 14413–14423. doi:10.1109/tvt.2020.3034800. ISSN 0018-9545. S2CID 228989788.

- ↑ Yoosefzadeh-Najafabadi, Mohsen; Hugh, Earl; Tulpan, Dan; Sulik, John; Eskandari, Milad (2021). "Application of Machine Learning Algorithms in Plant Breeding: Predicting Yield From Hyperspectral Reflectance in Soybean?". Front. Plant Sci. 11: 624273. doi:10.3389/fpls.2020.624273. PMC 7835636. PMID 33510761.

- ↑ 7.0 7.1 7.2 Bishop, C. M. (2006). Pattern Recognition and Machine Learning. Springer. ISBN 978-0-387-31073-2.

- ↑ การเรียนรู้ของเครื่องกับการรู้จำแบบ "มองได้ว่าเป็นสองแง่มุมของสาขาวิชาเดียวกัน"[7]: vii

- ↑ Friedman, Jerome H. (1998). "Data Mining and Statistics: What's the connection?". Computing Science and Statistics. 29 (1): 3–9.

- ↑ Samuel, Arthur (1959). "Some Studies in Machine Learning Using the Game of Checkers". IBM Journal of Research and Development. 3 (3): 210–229. CiteSeerX 10.1.1.368.2254. doi:10.1147/rd.33.0210. S2CID 2126705.

- ↑ Kohavi, R.; Provost, F. (1998). "Glossary of terms". Machine Learning. 30 (2–3): 271–274. doi:10.1023/A:1017181826899.

- ↑ Simon, Phil (18 มีนาคม 2013). Too Big to Ignore: The Business Case for Big Data. Wiley. p. 89. ISBN 978-1118638170.

- ↑ Gerovitch, Slava (9 เมษายน 2015). "How the Computer Got Its Revenge on the Soviet Union". Nautilus. คลังข้อมูลเก่าเก็บจากแหล่งเดิมเมื่อ 22 กันยายน 2021. สืบค้นเมื่อ 19 กันยายน 2021.

- ↑ Lindsay, Richard P. (1 กันยายน 1964). "The Impact of Automation On Public Administration". Western Political Quarterly (ภาษาอังกฤษ). 17 (3): 78–81. doi:10.1177/106591296401700364. ISSN 0043-4078. S2CID 154021253. เก็บจากแหล่งเดิมเมื่อ 6 ตุลาคม 2021. สืบค้นเมื่อ 6 ตุลาคม 2021.

- ↑ 15.0 15.1 15.2 "History and Evolution of Machine Learning: A Timeline". WhatIs (ภาษาอังกฤษ). สืบค้นเมื่อ 8 ธันวาคม 2023.

- ↑ Milner, Peter M. (1993). "The Mind and Donald O. Hebb". Scientific American. 268 (1): 124–129. Bibcode:1993SciAm.268a.124M. doi:10.1038/scientificamerican0193-124. ISSN 0036-8733. JSTOR 24941344. PMID 8418480.

- ↑ "Science: The Goof Button". ไทม์. 18 สิงหาคม 1961. เก็บจากแหล่งเดิมเมื่อ 7 พฤษภาคม 2021.

- ↑ Nilsson, N. (1965). Learning Machines. McGraw Hill – โดยทาง อินเทอร์เน็ตอาร์ไคฟ์.

- ↑ Duda, R.; Hart, P. (1973). Pattern Recognition and Scene Analysis. Wiley Interscience – โดยทาง อินเทอร์เน็ตอาร์ไคฟ์.

- ↑ Bozinovski, S. (1981). "Teaching space: A representation concept for adaptive pattern classification" (PDF). COINS Technical Report. Computer and Information Science Department, University of Massachusetts at Amherst, MA (81–28). คลังข้อมูลเก่าเก็บจากแหล่งเดิม (PDF)เมื่อ 24 กันยายน 2020.

- ↑ Harnad, Stevan (2008), "The Annotation Game: On Turing (1950) on Computing, Machinery, and Intelligence", ใน Epstein, Robert; Peters, Grace (บ.ก.), The Turing Test Sourcebook: Philosophical and Methodological Issues in the Quest for the Thinking Computer, Kluwer, คลังข้อมูลเก่าเก็บจากแหล่งเดิมเมื่อ 9 มีนาคม 2012, สืบค้นเมื่อ 4 กรกฎาคม 2015

- ↑ Sindhu V, Nivedha S, Prakash M (กุมภาพันธ์ 2020). "An Empirical Science Research on Bioinformatics in Machine Learning". Journal of Mechanics of Continua and Mathematical Sciences (7). doi:10.26782/jmcms.spl.7/2020.02.00006.

- ↑ Sarle, Warren S. (1994). "Neural Networks and statistical models". SUGI 19: proceedings of the Nineteenth Annual SAS Users Group International Conference. SAS Institute. pp. 1538–50. ISBN 9781555446116. OCLC 35546178.

- ↑ 24.0 24.1 24.2 24.3 Russell & Norvig 2003

- ↑ 25.0 25.1 Langley, Pat (2011). "The changing science of machine learning". Machine Learning. 82 (3): 275–9. doi:10.1007/s10994-011-5242-y.

- ↑ Le Roux, Nicolas; Bengio, Yoshua; Fitzgibbon, Andrew (2012). "Improving First and Second-Order Methods by Modeling Uncertainty". ใน Sra, Suvrit; Nowozin, Sebastian; Wright, Stephen J. (บ.ก.). Optimization for Machine Learning. MIT Press. p. 404. ISBN 9780262016469. เก็บจากแหล่งเดิมเมื่อ 17 มกราคม 2023. สืบค้นเมื่อ 12 พฤศจิกายน 2020.

- ↑ Bzdok, Danilo; Altman, Naomi; Krzywinski, Martin (2018). "Statistics versus Machine Learning". Nature Methods. 15 (4): 233–234. doi:10.1038/nmeth.4642. PMC 6082636. PMID 30100822.

- ↑ 28.0 28.1 Michael I. Jordan (10 กันยายน 2014). "statistics and machine learning". reddit. เก็บจากแหล่งเดิมเมื่อ 18 ตุลาคม 2017. สืบค้นเมื่อ 1 ตุลาคม 2014.

- ↑ Hung, Andrew J.; Chen, Jian; Gill, Inderbir S. (2018). "Automated Performance Metrics and Machine Learning Algorithms to Measure Surgeon Performance and Anticipate Clinical Outcomes in Robotic Surgery". JAMA Surgery. 153 (8): 770–771. doi:10.1001/jamasurg.2018.1512. PMC 9084629. PMID 29926095.

{{cite journal}}: CS1 maint: PMC format (ลิงก์) - ↑ Cornell University Library (สิงหาคม 2001). "Breiman: Statistical Modeling: The Two Cultures (with comments and a rejoinder by the author)". Statistical Science. 16 (3). doi:10.1214/ss/1009213726. S2CID 62729017. เก็บจากแหล่งเดิมเมื่อ 26 มิถุนายน 2017. สืบค้นเมื่อ 8 สิงหาคม 2015.

- ↑ Gareth James; Daniela Witten; Trevor Hastie; Robert Tibshirani (2013). An Introduction to Statistical Learning. Springer. p. vii. เก็บจากแหล่งเดิมเมื่อ 23 มิถุนายน 2019. สืบค้นเมื่อ 25 ตุลาคม 2014.

- ↑ Mohri, Mehryar; Rostamizadeh, Afshin; Talwalkar, Ameet (2012). Foundations of Machine Learning. US, Massachusetts: MIT Press. ISBN 9780262018258.

- ↑ Alpaydin, Ethem (2010). Introduction to Machine Learning. London: The MIT Press. ISBN 978-0-262-01243-0. สืบค้นเมื่อ 4 กุมภาพันธ์ 2017.

- ↑ Jordan, M. I.; Mitchell, T. M. (17 กรกฎาคม 2015). "Machine learning: Trends, perspectives, and prospects". Science. 349 (6245): 255–260. Bibcode:2015Sci...349..255J. doi:10.1126/science.aaa8415. PMID 26185243. S2CID 677218.

- ↑ El Naqa, Issam; Murphy, Martin J. (2015). "What is Machine Learning?". Machine Learning in Radiation Oncology. pp. 3–11. doi:10.1007/978-3-319-18305-3_1. ISBN 978-3-319-18304-6. S2CID 178586107.

- ↑ Okolie, Jude A.; Savage, Shauna; Ogbaga, Chukwuma C.; Gunes, Burcu (มิถุนายน 2022). "Assessing the potential of machine learning methods to study the removal of pharmaceuticals from wastewater using biochar or activated carbon". Total Environment Research Themes. 1–2: 100001. doi:10.1016/j.totert.2022.100001. S2CID 249022386.

บรรณานุกรม[แก้]

- Domingos, Pedro (22 กันยายน 2015). The Master Algorithm: How the Quest for the Ultimate Learning Machine Will Remake Our World. Basic Books. ISBN 978-0465065707.

- Nilsson, Nils (1998). Artificial Intelligence: A New Synthesis. Morgan Kaufmann. ISBN 978-1-55860-467-4. เก็บจากแหล่งเดิมเมื่อ 26 กรกฎาคม 2020. สืบค้นเมื่อ 18 พฤศจิกายน 2019.

- Russell, Stuart J.; Norvig, Peter (2003), Artificial Intelligence: A Modern Approach (2nd ed.), Upper Saddle River, New Jersey: Prentice Hall, ISBN 0-13-790395-2

- Poole, David; Mackworth, Alan; Goebel, Randy (1998). Computational Intelligence: A Logical Approach. New York: Oxford University Press. ISBN 978-0-19-510270-3. เก็บจากแหล่งเดิมเมื่อ 26 กรกฎาคม 2020. สืบค้นเมื่อ 22 สิงหาคม 2020.